Durante el último año y medio me ha estado rondando la cabeza la idea de tener más espacio de almacenamiento disponible en canelo, el servidor de casa pero quería hacerlo de una forma diferente a como hasta entonces, cuando añadía nuevos discos duros externos por USB. Además de generar calor, […]

Debian GNU/Linux

Resulta que hace unos meses me compré una tableta reMarkable, una de esas libretas digitales en las que escribes y lees como si fuese una Moleskine. Es una gozada, sinceramente y con una de las últimas actualizaciones ya fue el acabose, pudiendo escribir desde el ordenador, tableta o móvil, todo […]

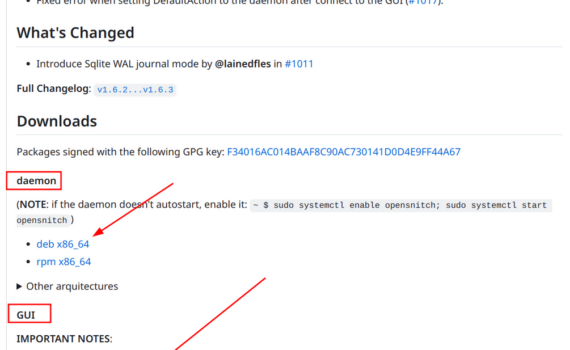

OpenSnitch, recuperando el control de tus conexiones (Actualizado 14/09/2023, compatible 100 % con Debian 12) Hoy quería recomendaros una aplicación que para mi se ha hecho imprescindible para mi. Hablo de OpenSnitch, un Firewall de aplicaciones para sistemas GNU/Linux que está basado en Little Snitch y escrito en Python. Una […]

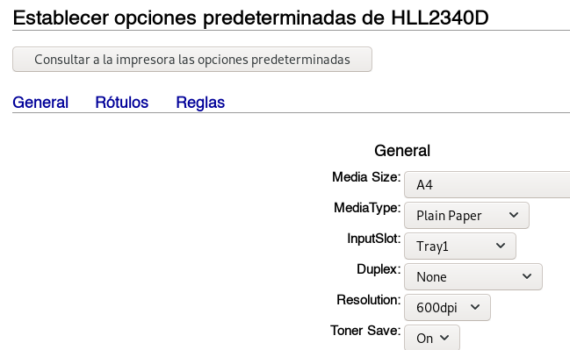

Entrada lo más resumida posible debido a mi falta de tiempo para explayarme más . Si tienes prisa, ve directamente al final en «la solución». Situación y de dónde vino el problema: Yo usaba Debian Testing desde 2019 y esta impresora en mis Debian desde hace unos 5 años y […]

No nos engañemos, si lees esto muy probablemente seas el soporte informático de alguien. En mi caso particular, soy el soporte informático de familia y amigos en dos países y cinco comunidades autónomas y lo decirles «mejor me conecto y lo miro» es ya un clásico, tanto que mi padre […]

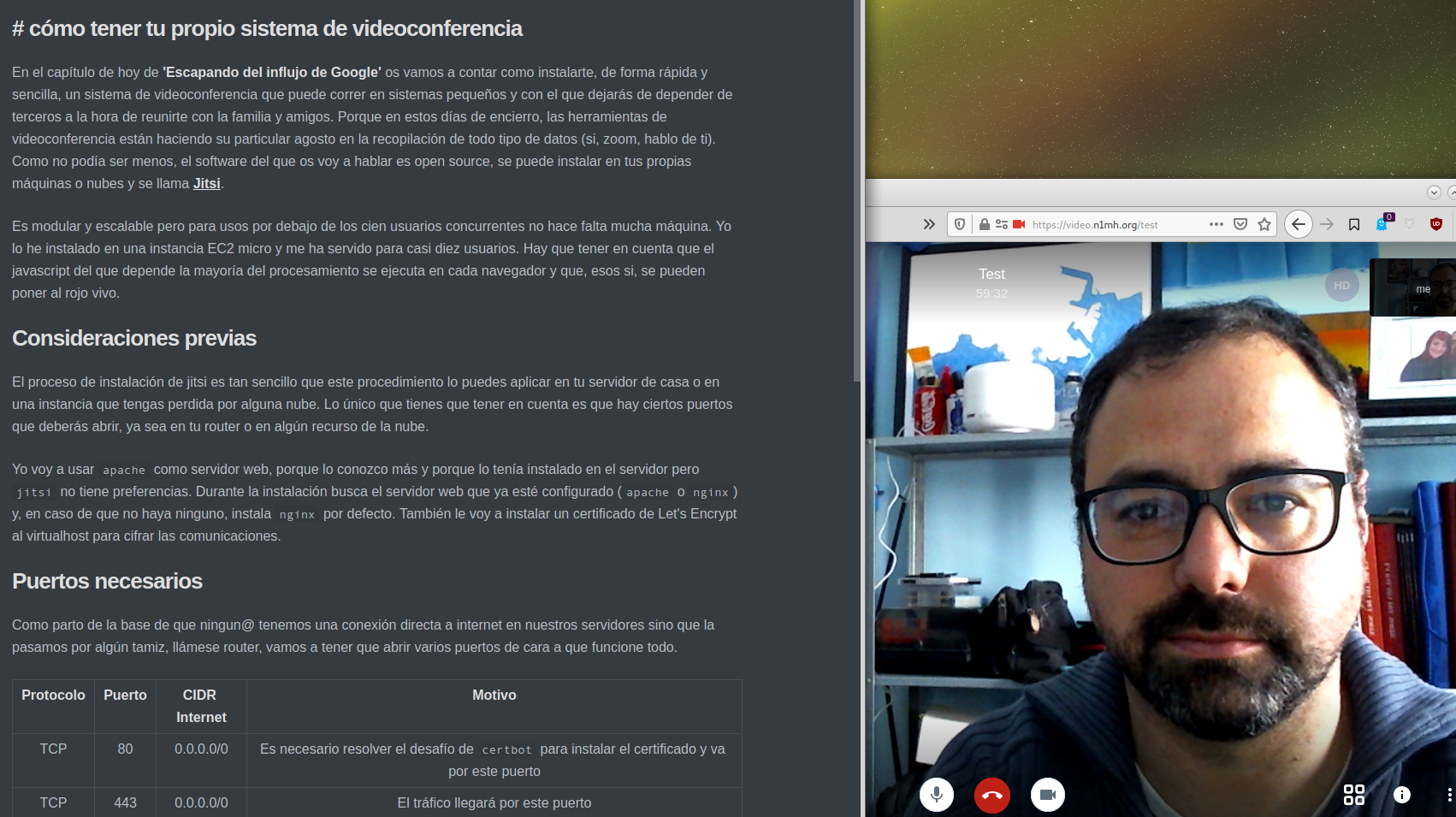

En el capítulo de hoy de ‘Escapando del influjo de Google’ os vamos a contar como instalarte, de forma rápida y sencilla, un sistema de videoconferencia que puede correr en sistemas pequeños y con el que dejarás de depender de terceros a la hora de reunirte con la familia y […]

Si en el chromebook falla la actualización de paquetes de debian del repositorio de Crostini, es porque la llave gpg ha caducado, uno de esos errores que uno no entiende y menos viniendo del mismísimo oráculo. El error en concreto es este: Y la solución es sencilla aunque está escondida. […]

Anastasia es una recién llegada a un montón de cosas: a debianhackers, a la administración de sistemas y, un poco menos, a linux. Pero suple su falta de experiencia con muchas ganas y batallando como una auténtica profesional. También su bisoñez le lleva a ver este sector, habitado por muchos […]

¡Me encanta el olor a software libre por las mañanas! Y más cuando una aplicación privativa que me gusta se vuelve un dolor de muelas por sus restricciones. Entonces es el momento de buscar alternativas de software libre. mis requerimientos open source alternativa a slack multiplataforma: linux, windows, android… sin […]